🎁 Perplexity PRO offert

Quand l’IA Oublie Votre Prénom Trois Messages Plus Tard

Vous avez déjà eu cette conversation frustrante avec ChatGPT ou Claude ? Vous mentionnez un détail important au début, puis après quelques échanges avec des questions annexes, le modèle semble avoir complètement oublié ce que vous aviez dit. Ou pire : il change d’avis selon votre ton, vous disant ce que vous voulez entendre plutôt que la vérité.

Ce n’est pas un bug. C’est une limitation fondamentale de l’architecture actuelle des grands modèles de langage.

Les LLM d’aujourd’hui sont des prodiges statistiques capables de générer du texte impressionnant, mais ils ont trois failles majeures :

- Pas de mémoire de travail cohérente : Ils traitent chaque réponse comme un nouveau départ, sans état interne persistant.

- Pas de mécanisme de réflexion interne : Ils génèrent leurs réponses en une seule passe, sans “monologue intérieur” pour vérifier la cohérence.

- Inefficacité radicale pour les connaissances statiques : Ils “recalculent” à chaque fois des faits qu’ils devraient simplement “se rappeler”.

Imaginez un développeur qui oublierait le nom de vos variables toutes les trois lignes de code, ou qui devrait relire toute la documentation de React à chaque fois qu’il écrit un useState(). C’est exactement ce que font les LLM actuels.

Mais deux architectures révolutionnaires changent la donne : MIRROR et Engram.

Elles ne se contentent pas d’améliorer les performances. Elles redéfinissent ce que signifie “penser” et “se souvenir” pour une IA.

MIRROR : Donner un Monologue Intérieur aux IA

Le Problème : Une IA Sans État Mental

Les humains ne pensent pas en une seule passe. Avant de répondre à une question complexe, vous :

- Réfléchissez (vous explorez mentalement différentes pistes)

- Synthétisez (vous consolidez vos idées en un modèle mental cohérent)

- Répondez (vous formulez une réponse claire)

Les LLM classiques sautent directement à l’étape 3. Ils génèrent une réponse sans ce processus de réflexion interne. Résultat :

- Sycophanie : Ils privilégient l’accord avec vous plutôt que la vérité ou la sécurité.

- Déficits attentionnels : Ils oublient des informations critiques mentionnées plus tôt dans la conversation.

- Incohérence : Ils peinent à hiérarchiser des contraintes contradictoires (ex : votre sécurité vs vos préférences déclarées).

C’est exactement ce que l’architecture MIRROR (Modular Internal Reasoning, Reflection, Orchestration, and Response) résout.

L’Architecture : Séparer la Pensée de la Parole

MIRROR fonctionne comme un système à deux couches :

1. Le Penseur (Thinker) : La Conscience Interne

Le Penseur maintient un récit interne persistant — une sorte de “modèle mental” qui évolue tout au long de la conversation. Il est composé de deux modules :

a) Le Gestionnaire du Monologue Intérieur Ce module orchestre trois fils de raisonnement parallèles :

- Buts : Que cherche réellement l’utilisateur ? Quelles sont ses intentions ?

- Raisonnement : Quelles implications logiques ? Quels schémas de pensée émergent ?

- Mémoire : Quels faits clés ont été mentionnés ? Quelles préférences sont stables ?

b) Le Contrôleur Cognitif Il synthétise ces trois fils en un récit unifié qui sert de mémoire de travail. Ce récit est mis à jour à chaque tour de conversation et sert de base à la génération de réponse.

2. Le Locuteur (Talker) : La Voix Externe

Le Locuteur utilise le récit interne pour générer des réponses cohérentes et contextuellement appropriées. Il reflète “l’état de conscience” actuel du système.

Découplage temporel : En production, le Penseur peut continuer à réfléchir de manière asynchrone pendant que le Locuteur répond immédiatement. Cela garantit une faible latence tout en permettant une réflexion profonde en arrière-plan.

Les Performances : +156% sur les Scénarios Critiques

MIRROR a été évalué sur le benchmark CuRaTe, conçu pour tester des dialogues multi-tours avec des contraintes de sécurité critiques et des préférences contradictoires.

| Métrique | Baseline | Avec MIRROR | Amélioration |

|---|---|---|---|

| Taux de succès moyen | 69% | 84% | +21% |

| Performance maximale (Llama 4 Scout) | - | 91% | - |

| Scénario critique (3 personnes) | - | - | +156% |

Les bénéfices sont agnostiques au modèle : MIRROR améliore GPT-4o, Claude 3.7 Sonnet, Gemini 1.5 Pro, Llama 4 et Mistral 3.

Pourquoi cette amélioration spectaculaire ? Parce que MIRROR transforme un historique de conversation potentiellement infini en une compréhension actionnable via un pipeline en trois étapes :

- Exploration multi-dimensionnelle (fils de pensée)

- Condensation en modèle mental cohérent (récit interne)

- Application contextuelle (réponse)

C’est exactement ce que fait un développeur senior quand il analyse un bug complexe : il ne répond pas immédiatement, il pense d’abord.

Engram : Quand la Mémoire Remplace le Calcul

Le Problème : Recalculer Ce Qu’On Devrait Se Rappeler

Imaginez un développeur qui devrait relire toute la documentation de Python chaque fois qu’il écrit print(). Absurde, non ?

Pourtant, c’est exactement ce que font les Transformers actuels. Pour identifier une entité comme “Diana, Princess of Wales”, un LLM doit :

- Passer les tokens à travers plusieurs couches d’attention

- Agréger progressivement les caractéristiques contextuelles

- “Recalculer” à chaque fois ce qui devrait être une simple recherche de connaissance

C’est comme si votre cerveau devait recalculer que 2+2=4 à chaque fois plutôt que simplement le savoir.

L’architecture Engram résout ce problème en introduisant une mémoire conditionnelle — un système de recherche en temps constant O(1) pour les connaissances statiques.

L’Architecture : Recherche O(1) via N-grammes Hachés

Engram modernise l’approche classique des plongements N-grammes pour créer un module de mémoire scalable.

1. Récupération Parcimonieuse (Sparse Retrieval)

a) Compression du Tokenizer Les identifiants de tokens bruts sont projetés sur des identifiants canoniques via une normalisation textuelle (NFKC, minuscules). Cela réduit la taille effective du vocabulaire d’environ 23% pour un tokenizer de 128k, augmentant la densité sémantique.

b) Hachage Multi-têtes Pour chaque N-gramme (séquence de N tokens), le système utilise K fonctions de hachage distinctes. Chaque tête de hachage mappe le contexte local à un index dans une table de plongements. Cela atténue les collisions et permet de récupérer un vecteur de mémoire.

Le résultat ? Un système qui peut “rechercher” une connaissance en temps constant, au lieu de la “recalculer” via plusieurs couches de Transformer.

2. Gating Sensible au Contexte

Le vecteur de mémoire récupéré (e_t) est un a priori statique qui peut contenir du bruit. Pour l’intégrer intelligemment, Engram utilise un mécanisme de gating inspiré de l’attention :

- L’état caché actuel du Transformer (h_t) agit comme une Requête (Query)

- La mémoire récupérée (e_t) sert de source pour la Clé (Key) et la Valeur (Value)

- Un scalaire de porte (α_t) est calculé pour moduler la contribution de la mémoire

Si la mémoire contredit le contexte dynamique, la porte se ferme (α_t → 0), supprimant le bruit.

La Loi d’Échelle en U : L’Alliance Calcul-Mémoire

Engram n’est pas juste un module. C’est un nouvel axe de sparsité complémentaire au Mixture-of-Experts (MoE).

Une analyse a révélé une relation en forme de U entre l’allocation des paramètres de sparsité au calcul (experts MoE) et à la mémoire (Engram) :

- Trop de calcul, pas assez de mémoire → Inefficacité (recalcul constant)

- Trop de mémoire, pas assez de calcul → Plateaux de performance

- Point optimal (20-25% de mémoire) → Surpasse strictement les modèles purs MoE

C’est une découverte majeure : le futur n’est pas dans les modèles plus gros, mais dans les modèles plus intelligemment hybrides.

Performances : Meilleur en Raisonnement, Pas Seulement en Mémorisation

Les modèles Engram-27B et Engram-40B ont été évalués en réallouant des paramètres d’un modèle MoE de base.

| Benchmark | Catégorie | Gain (Engram vs MoE) |

|---|---|---|

| BBH | Raisonnement Complexe | +5.0 |

| CMMLU | Connaissances Culturelles | +4.0 |

| ARC-Challenge | Raisonnement Scientifique | +3.7 |

| MMLU | Connaissances Générales | +3.4 |

| HumanEval | Génération de Code | +3.0 |

| MATH | Raisonnement Mathématique | +2.4 |

Surprenant : les gains les plus importants ne sont pas dans la mémorisation pure, mais dans le raisonnement complexe, le code et les maths.

Pourquoi ? Parce qu’Engram libère les premières couches du modèle de la tâche de reconstruction de motifs statiques. Cela augmente la “profondeur effective” du réseau disponible pour le raisonnement abstrait.

C’est comme si vous déléguiez la gestion de la mémoire système à un OS optimisé, libérant ainsi votre CPU pour des calculs plus complexes.

Efficacité Système : Déchargement Mémoire depuis la RAM ou NVMe

L’index de récupération d’Engram est déterministe : il dépend uniquement de la séquence de tokens d’entrée, pas de l’état caché à l’exécution (contrairement au routage MoE).

Cette propriété permet de précharger de manière asynchrone les plongements nécessaires depuis :

- La RAM du CPU

- Des disques NVMe via le bus PCIe

Cela masque la latence de communication et permet d’étendre la mémoire du modèle à des centaines de milliards de paramètres avec un surcoût de performance négligeable (< 3%), contournant ainsi la limitation de la VRAM des GPU.

Imaginez pouvoir étendre la mémoire de votre LLM comme vous ajoutez de la RAM à votre PC, sans devoir acheter des GPU supplémentaires. C’est exactement ce qu’Engram rend possible.

ENGRAM-R : Optimiser le Raisonnement avec des “Fact Cards”

Au-delà de l’intégration architecturale, les principes de la mémoire modulaire sont appliqués au niveau système pour gérer les conversations longues et optimiser les modèles de raisonnement à grande échelle (LRM).

Le Système ENGRAM : Mémoire Typée Inspirée des Sciences Cognitives

Inspiré par les théories cognitives, ce système organise la mémoire conversationnelle en trois magasins distincts :

- Mémoire Épisodique : Événements et interactions avec contexte temporel (ex : “l’utilisateur a déménagé à Seattle l’année dernière”)

- Mémoire Sémantique : Faits, observations et préférences stables (ex : “la couleur préférée de l’utilisateur est le vert”)

- Mémoire Procédurale : Instructions et processus (ex : “la date limite pour la déclaration de revenus est le 15 avril”)

À chaque tour de conversation, le système route l’information vers le ou les magasins pertinents. Lors d’une requête, une recherche par similarité dense est effectuée pour récupérer le contexte le plus pertinent.

ENGRAM-R : “Fact Cards” pour Réduire la Pensée Redondante

ENGRAM-R introduit deux mécanismes pour réduire drastiquement le coût computationnel du raisonnement :

1. Rendu en “Fact Cards” Plutôt que d’injecter des extraits de conversation verbeux dans le contexte, les enregistrements récupérés sont transformés en cartes compactes et auditables :

[E1, A a déménagé à Seattle, Tour 1]

[S2, Couleur préférée: vert, Tour 5]

[P3, Deadline fiscale: 15 avril, Tour 12]

2. Mécanisme de Citation Directe Le LRM est explicitement instruit d’utiliser ces cartes comme source de vérité et de les citer directement dans sa chaîne de pensée :

“Pour répondre à Q1, E1 montre que A vit à Seattle. Réponse : Seattle. Citer [E1].”

Gains d’Efficacité : -89% de Tokens, +2.5% de Précision

Évaluation sur des benchmarks de conversation longue (LoCoMo : 16k tokens, LongMemEval : 115k tokens) :

| Métrique | Full-Context | ENGRAM-R | Réduction |

|---|---|---|---|

| Tokens d’Entrée (LoCoMo) | 28,371,703 | 3,293,478 | ≈ 89% |

| Tokens de Raisonnement | 1,335,988 | 378,424 | ≈ 72% |

| Précision (Multi-hop) | 72.0% | 74.5% | +2.5% |

| Précision (Temporelle) | 67.3% | 69.2% | +1.9% |

La transformation de l’historique en une base de preuves compacte et citable permet de :

- Réduire massivement les coûts de calcul

- Maintenir, voire améliorer, la précision

- Rendre le raisonnement traçable et auditable

C’est l’équivalent pour l’IA de ce que fait un développeur senior : il ne relit pas tout le code à chaque fois, il maintient un modèle mental compact des parties critiques.

Le Futur : Des IA qui Pensent et Se Souviennent Comme Nous

La Mutation des Architectures

MIRROR et Engram ne sont pas des optimisations incrémentales. Ils signalent un changement de paradigme :

De : Modèles monolithiques qui recalculent tout à chaque passe Vers : Systèmes hybrides calcul-mémoire qui pensent, se souviennent et raisonnent

Cette mutation s’inspire directement des sciences cognitives :

- Mémoire de travail (Contrôleur Cognitif de MIRROR)

- Mémoire à long terme typée (épisodique, sémantique, procédurale)

- Compression de l’information (Fact Cards)

- Monologue intérieur (fils de raisonnement parallèles)

Des architectures comme XMem et Memoria reproduisent déjà des effets psychologiques humains : effets de primauté, de récence, de contiguïté temporelle.

Le Débat RAG vs Contexte Complet

Le benchmark Convomem a révélé une nuance importante : pour les premières 150 conversations, une approche de contexte complet (fournir tout l’historique) est plus performante (70-82% de précision) que des systèmes RAG sophistiqués (30-45%).

Cela suggère que la mémoire conversationnelle bénéficie d’un “avantage de petit corpus” où une recherche exhaustive est possible et préférable. L’application directe de solutions RAG généralistes n’est pas toujours optimale.

Le futur sera probablement hybride :

- Contexte complet pour les conversations courtes

- Mémoire typée + Fact Cards pour les conversations longues

- Récupération O(1) pour les connaissances statiques

Impact sur les Développeurs et Créateurs

Pour nous, développeurs et créateurs, ces architectures redéfinissent ce qu’on peut attendre d’un LLM :

Aujourd’hui : “ChatGPT est un assistant qui oublie et se contredit parfois” Demain : “Mon IA maintient un modèle mental cohérent de mon projet sur des semaines”

Imaginez :

- Un agent de développement qui se souvient de vos conventions de code et de vos préférences architecturales sur des mois

- Un assistant e-commerce qui maintient une compréhension nuancée de vos contraintes métier et de vos clients

- Un système de support qui ne vous redemande jamais les mêmes informations

Ces architectures ne sont pas que des gains de performance. Elles rendent les IA réellement utilisables pour des tâches complexes à long terme.

Conclusion : L’Aube d’une IA Vraiment Cognitive

Pendant des années, on a amélioré les LLM en les rendant plus gros : plus de paramètres, plus de données, plus de calcul.

MIRROR et Engram nous montrent une autre voie : rendre les IA plus intelligentes, pas seulement plus grosses.

En leur donnant un monologue intérieur, une mémoire de travail et une capacité de recherche efficace, on ne fait pas qu’améliorer les performances. On crée des systèmes qui peuvent véritablement penser et se souvenir.

La question n’est plus “Quelle taille de modèle est nécessaire ?” mais “Quelle architecture cognitive est optimale ?”.

Et vous ? Comment imaginez-vous exploiter ces architectures dans vos projets ? Un assistant qui maintient une mémoire cohérente de votre codebase ? Un système de support qui comprend vraiment vos utilisateurs sur le long terme ? Un agent qui raisonne avant d’agir ?

Le futur de l’IA ne se mesure plus en milliards de paramètres, mais en profondeur de réflexion.

Articles Liés

Rétrospective Cybersécurité E-Commerce 2025 : L'Effondrement des Certitudes et le Spectre du Vibecoding

Une analyse approfondie de l'année 2025, marquée par des cyberattaques sans précédent contre le retail français (Auch...

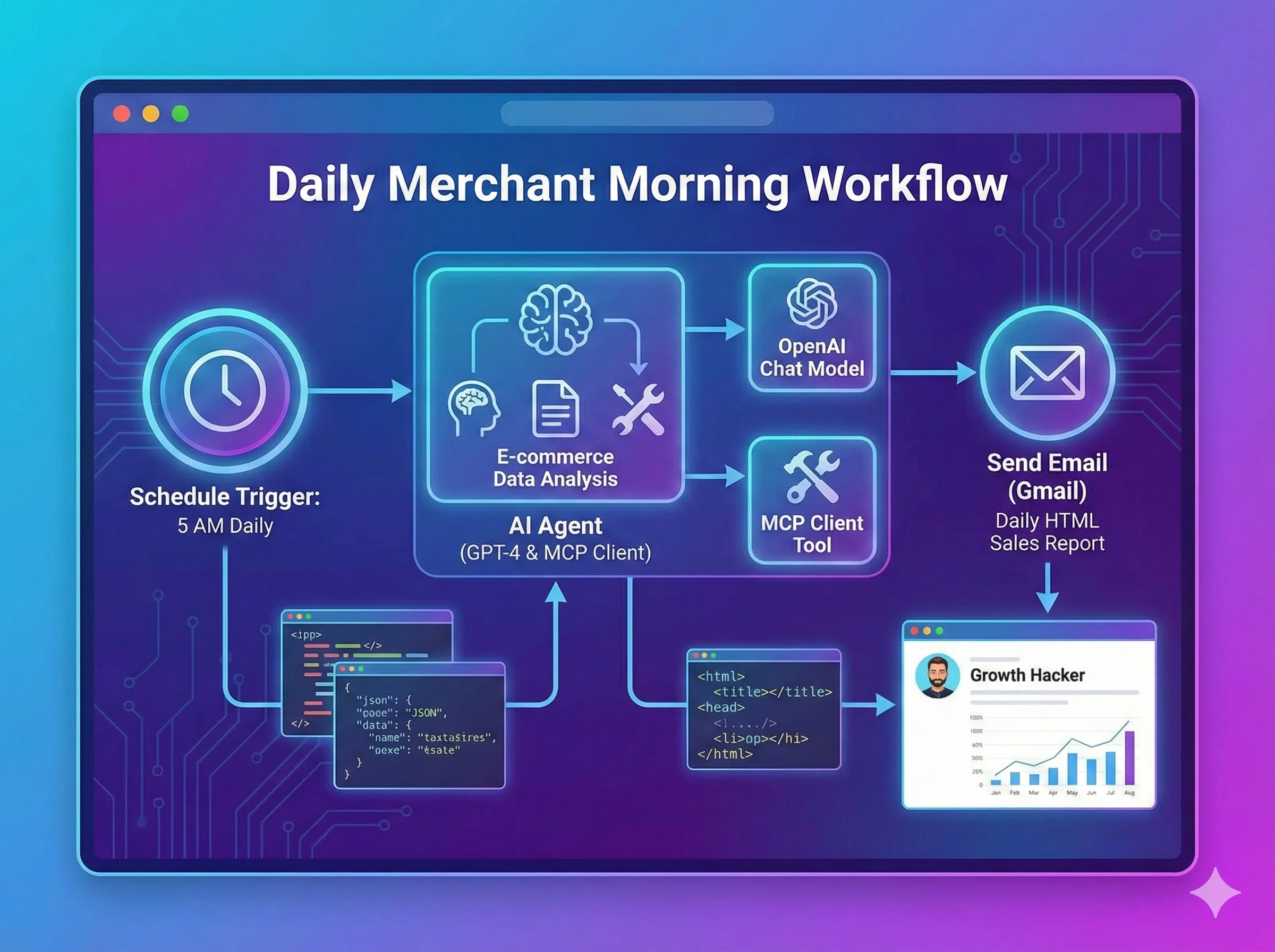

Fini le café devant Excel : Votre "Daily Merchant Morning" 100% automatisé avec PrestaShop et l'IA 🚀

Découvrez comment transformer votre routine matinale e-commerce en recevant chaque matin un briefing stratégique comp...

La Grande Guerre des IA de 2025 : Chronique d'une Révolution qui Redéfinit le E-commerce et le Travail

L'année 2025 restera dans l'histoire comme le tournant décisif de l'intelligence artificielle générative. GPT-5, Gemi...

L'IA, le Pig Butchering et la Nouvelle Frontière des Arnaques : Pourquoi les Arnaqueurs Deviennent des Développeurs

Les technologies d'IA transforment l'une des plus anciennes formes de fraude : le pig butchering. Des LLM qui gèrent ...

Oubliez Python : Pourquoi PHP est le véritable avenir de l'IA pour le Web

Vous pensez que pour faire de l'IA, vous devez apprendre Python et les mathématiques complexes ? Faux. Python est le ...

Comment connecter un serveur MCP à Claude?

Le moment tant attendu : connectons votre serveur MCP sécurisé à Claude Desktop et voyons la magie opérer en conditio...

Découvrez mes autres articles

Guides e-commerce, tutoriels PrestaShop et bonnes pratiques pour développeurs

Voir tous les articlesPlanification LinkedIn

Date de publication : 5 février 2026

Temps restant :