🎁 Perplexity PRO offert

🧠 Et si l’IA rejetait ton code pour de mauvaises raisons ?

Les biais cachés des outils de code review automatisés

⚡ Imagine la scène

Tu soumets ta pull request. Tout est propre, testé, fonctionnel. Mais ton code est rejeté.

Non pas parce qu’il est mauvais… Mais parce qu’une IA pense qu’il l’est.

Le commentaire automatique s’affiche :

❌ “This method seems inefficient. Consider refactoring.”

Sauf que — tu le sais — ton approche est volontaire. Optimisée pour ton contexte métier. Et là, une question t’effleure : 👉 Et si l’IA n’était pas aussi neutre qu’on le croit ?

💡 La promesse (trop belle) de l’IA dans le code review

Ces dernières années, les outils de code review automatisée se sont imposés comme des alliés incontournables des développeurs. GitHub Copilot, SonarQube, Amazon CodeWhisperer, Codacy… tous promettent de rendre le code “meilleur, plus rapide, plus sûr”.

L’argument est séduisant :

- Moins de bugs.

- Un style cohérent.

- Une productivité accrue.

Et surtout, une évaluation “objective” du code. L’IA n’a pas d’ego, pas de biais humains… en théorie.

Mais dans la réalité, aucune IA n’est neutre. Car toute IA est le reflet de ses données, de ses concepteurs et de leurs choix d’entraînement. Autrement dit : nos outils de review reproduisent, à leur manière, nos propres angles morts.

🧬 Où naissent les biais : sous le capot des reviewers intelligents

1. Les biais d’entraînement

Les modèles qui évaluent ton code apprennent à partir d’énormes volumes de données publiques — souvent issus de GitHub, Stack Overflow ou de projets open-source populaires.

Problème :

- Ces projets proviennent majoritairement de développeurs occidentaux, anglophones,

- écrits dans certains langages dominants (Python, JavaScript, Java),

- et respectant des conventions précises (PEP8, PSR-12…).

Résultat : si ton code ne ressemble pas à ce qu’ils connaissent, il sera jugé… anormal. Pas faux, pas dangereux, juste hors norme. Et c’est là que le biais commence.

2. Les biais d’évaluation

Les IA ont tendance à valoriser le code qu’elles ont le plus vu. Un modèle “préférera” :

- une fonction verbeuse à une lambda concise,

- un design pattern mainstream à une approche plus minimaliste,

- un commentaire inutile plutôt qu’un code auto-documenté.

Pourquoi ? Parce que dans ses données, ces formes apparaissent comme “bonnes pratiques”. Pas parce qu’elles le sont dans ton contexte.

3. Les biais de contexte

Un reviewer humain comprend les contraintes d’un projet : dette technique, compatibilité, performance, priorité business. L’IA, elle, ne voit que le code. Et sans contexte, elle interprète mal. Ce qu’elle perçoit comme une “inefficacité” peut en réalité être un compromis parfaitement maîtrisé.

⚖️ Des exemples qui parlent

🧾 Cas n°1 — Le code trop concis. Un dev écrit une fonction élégante, trois lignes, purement fonctionnelle. L’IA commente :

“This code is hard to read. Consider expanding logic.” Traduction : je n’ai pas compris, donc c’est mauvais.

🧾 Cas n°2 — Les conventions non-anglophones.

Une variable prix_total est signalée comme non conforme :

“Variable name should be in English.” Pourquoi ? Parce que l’IA a appris que “good code” = anglais. Le code est pourtant clair, cohérent, localisé — mais jugé négativement.

🧾 Cas n°3 — Le mot interdit.

Un reviewer automatique bloque une PR contenant blacklist et whitelist, sans contexte.

L’intention était technique (listes IP), mais la correction automatique crée un faux positif.

Encore une fois, la machine ne comprend pas le sens, seulement la corrélation.

🚨 Les conséquences invisibles

Ces biais ne sont pas anodins. Petit à petit, ils modifient nos comportements :

- on s’aligne inconsciemment sur les conventions majoritaires,

- on évite les structures “atypiques”,

- on écrit pour plaire à la machine, pas pour l’humain.

Et dans les grandes entreprises, où ces systèmes de review sont intégrés dans la CI/CD, le biais devient systémique. Un code “mal noté” peut retarder un déploiement, fausser une évaluation de performance, voire influencer des décisions RH. Le risque n’est plus seulement technique — il devient organisationnel.

🧩 Comment rendre les IA de review plus justes ?

1. Diversifier les jeux de données

Former les modèles sur des codes variés : langues, styles, structures, contraintes. Sortir du prisme GitHub “par défaut”.

2. Réintroduire l’humain

Les IA doivent assister, pas juger seules. Un système de human-in-the-loop permet de contextualiser, valider, nuancer les verdicts.

3. Documenter la logique du modèle

Transparence = confiance. Les outils de review devraient expliquer pourquoi un code est jugé problématique, et sur quelle base. Une explication claire vaut mille alertes automatiques.

4. Former les développeurs à détecter le biais

Apprendre à reconnaître quand un feedback IA est légitime… ou arbitraire. L’éthique du code devient une compétence à part entière.

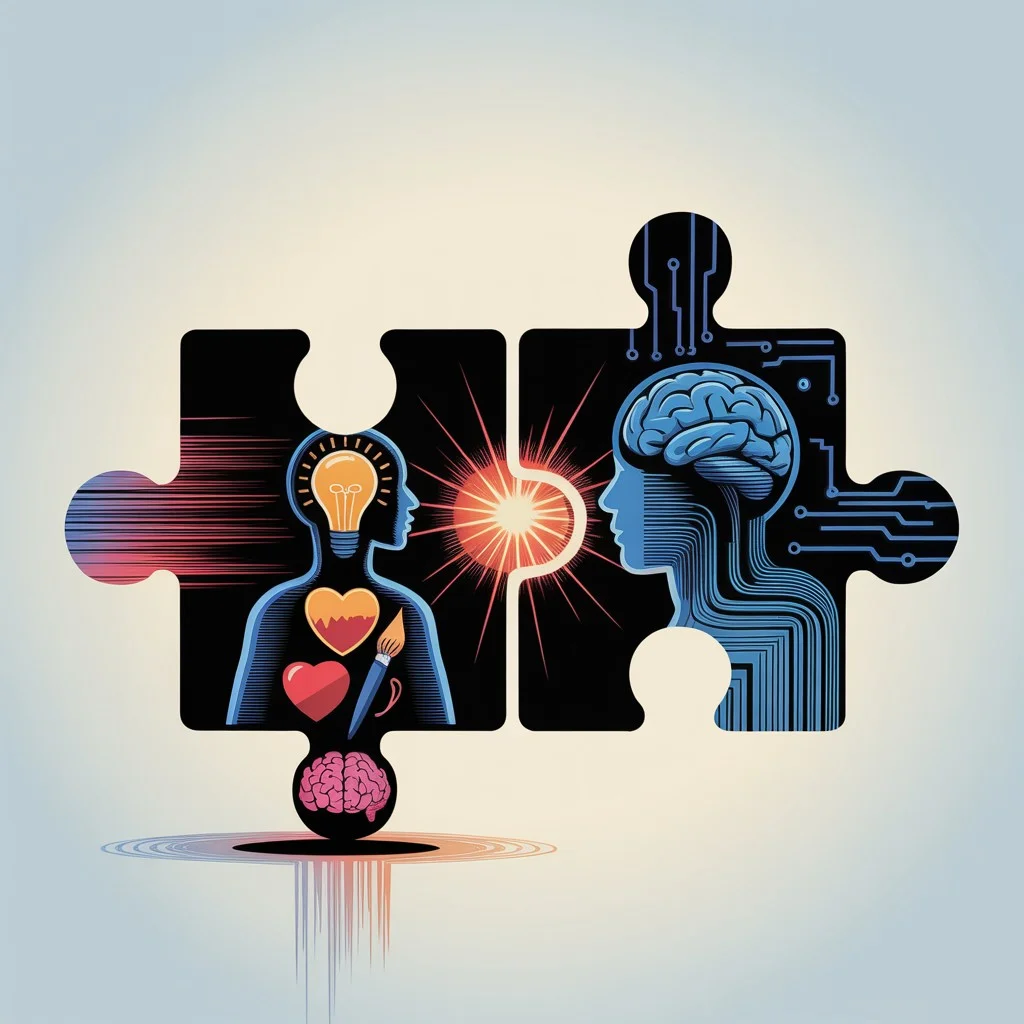

🚀 Vers une nouvelle éthique du développement

Nous entrons dans une ère fascinante où l’IA ne se contente plus de générer du code — elle le juge. Mais si nous voulons que cette évolution soit bénéfique, il faut rétablir la symétrie : l’humain garde la responsabilité, la machine apporte l’assistance.

Le bon code, ce n’est pas celui qui plaît à une IA. C’est celui qui sert son utilisateur, respecte son contexte et garde une intention claire.

L’avenir du développement ne se jouera pas seulement sur la productivité… Il se jouera sur la justice algorithmique dans nos outils.

💬 Pour aller plus loin

Ce sujet soulève une question essentielle : jusqu’où peut-on déléguer notre jugement à une machine ?

Nous faisons confiance à l’IA pour détecter nos erreurs, mais parfois, elle en invente d’autres. Et si, à force de vouloir automatiser la qualité, nous finissions par automatiser le conformisme ?

Le futur du code ne dépend pas seulement de ce que nous écrivons, mais de ce que nous acceptons de laisser juger à notre place.

Réfléchir à ces biais, c’est déjà faire un pas vers une IA plus juste — et vers un développement qui reste profondément humain.

Questions Fréquentes

Pourquoi les outils de code review IA ne sont-ils pas neutres ?

Aucune IA n’est neutre car toute IA est le reflet de ses données, concepteurs et choix d’entraînement. Les modèles apprennent principalement sur du code occidental anglophone dans certains langages dominants. Si votre code ne ressemble pas à ce qu’ils connaissent, il sera jugé anormal, pas faux, juste hors norme.

Quels sont les principaux types de biais dans les reviewers IA ?

Les biais d’entraînement (données majoritairement occidentales anglophones), les biais d’évaluation (préférence pour les formes les plus vues même si non optimales dans votre contexte), et les biais de contexte (l’IA ne comprend pas vos contraintes métier, dette technique, priorités business).

Comment les biais IA affectent-ils concrètement les développeurs ?

Les développeurs s’alignent inconsciemment sur conventions majoritaires, évitent structures atypiques, écrivent pour plaire à la machine plutôt qu’aux humains. Dans les grandes entreprises avec review automatisé en CI/CD, le biais devient systémique : un code mal noté peut retarder déploiement, fausser évaluation de performance, influencer décisions RH.

Comment rendre les IA de review plus justes ?

Diversifier les jeux de données (langues, styles, structures variés), réintroduire l’humain avec système human-in-the-loop pour contextualiser, documenter la logique du modèle (expliquer pourquoi un code est jugé problématique), et former développeurs à détecter quand un feedback IA est légitime ou arbitraire.

Faut-il faire confiance aux outils de code review automatisés ?

Les IA doivent assister, pas juger seules. Le bon code n’est pas celui qui plaît à une IA, mais celui qui sert son utilisateur, respecte son contexte et garde une intention claire. L’humain garde la responsabilité finale, la machine apporte l’assistance. Déléguer totalement le jugement risque d’automatiser le conformisme.

Claude est-il gratuit?

Claude propose une version gratuite limitée et des abonnements Pro (20$/mois) et Team (30$/mois par utilisateur).

Articles Liés

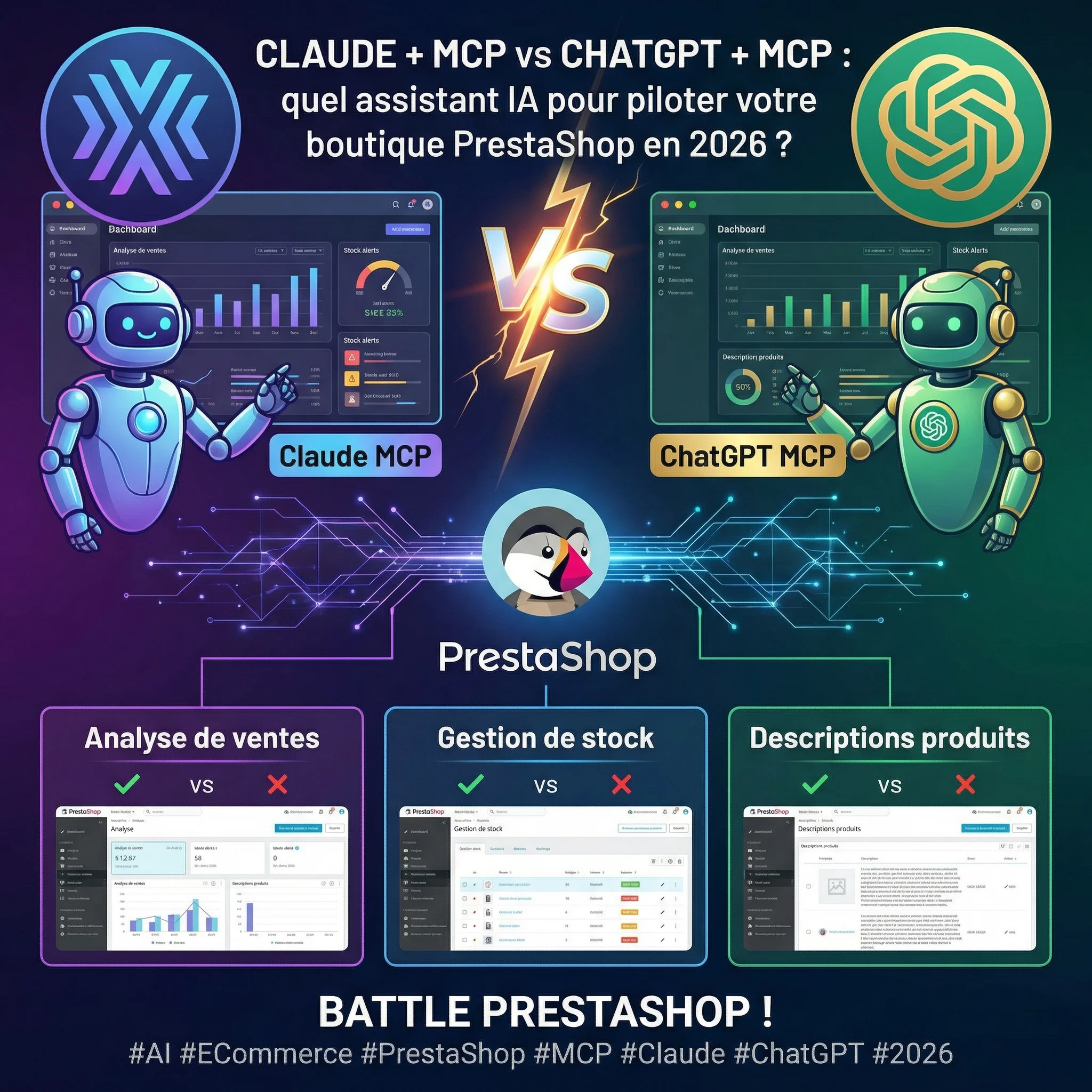

Claude + MCP Tools Plus vs ChatGPT + MCP Tools Plus : Quel assistant IA pour piloter votre boutique PrestaShop en 2026 ?

Claude ou ChatGPT pour gérer votre boutique PrestaShop ? Test comparatif réel avec MCP Tools Plus sur 5 épreuves e-co...

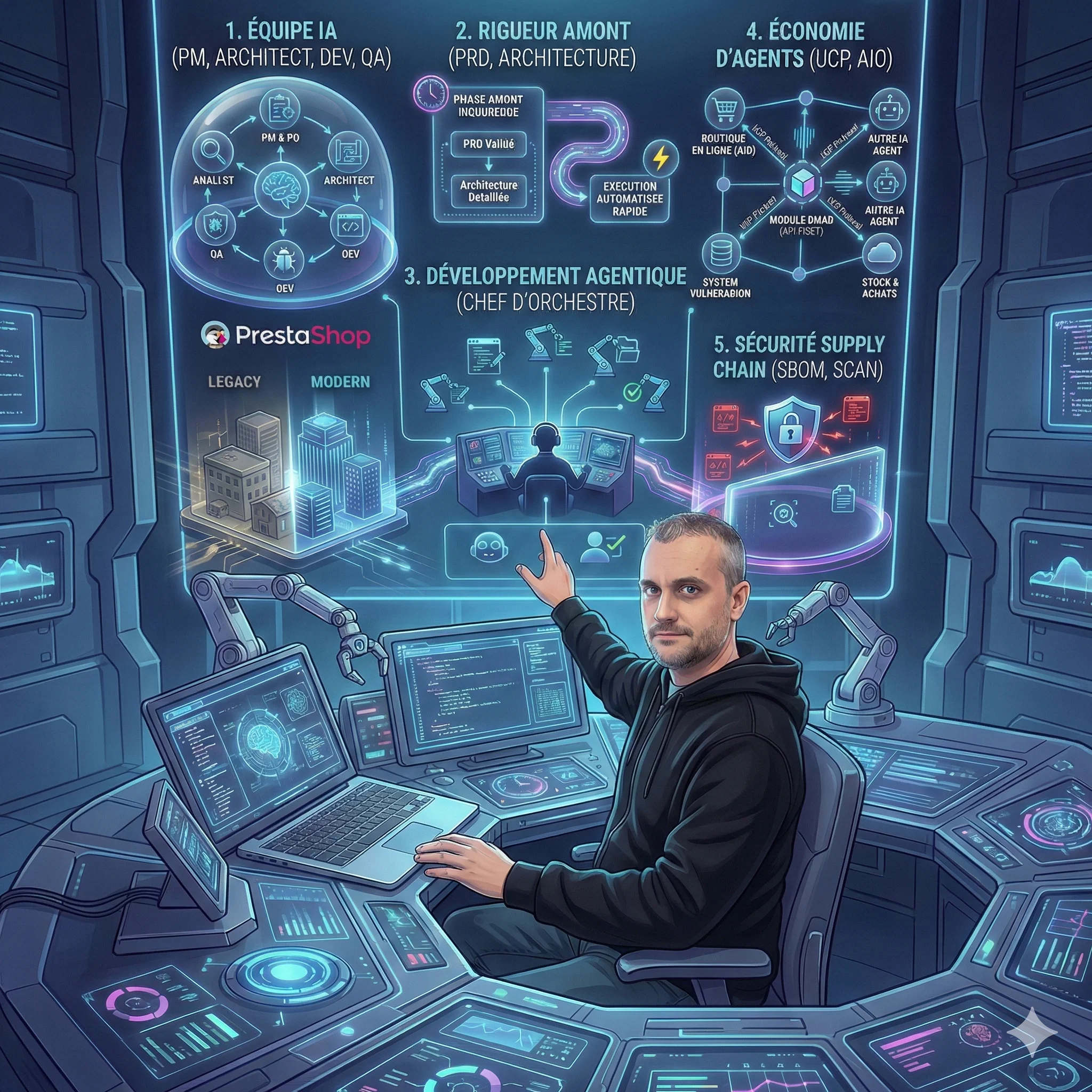

5 révélations surprenantes de la méthode BMAD sur l'avenir du développement de modules

La méthode BMAD révèle des enseignements inattendus sur le futur du développement de modules. De l'IA comme équipe pr...

8 tendances qui redéfinissent le développement logiciel en 2026

L'article d'Anthropic révèle une transformation majeure du développement logiciel en 2026. Du codage agentique à la s...

😰 92% ont peur de l'IA, mais seuls 22% l'ont testée

L'IA ne remplace pas votre emploi, elle transforme votre façon de travailler. Guide pratique pour passer de la peur à...

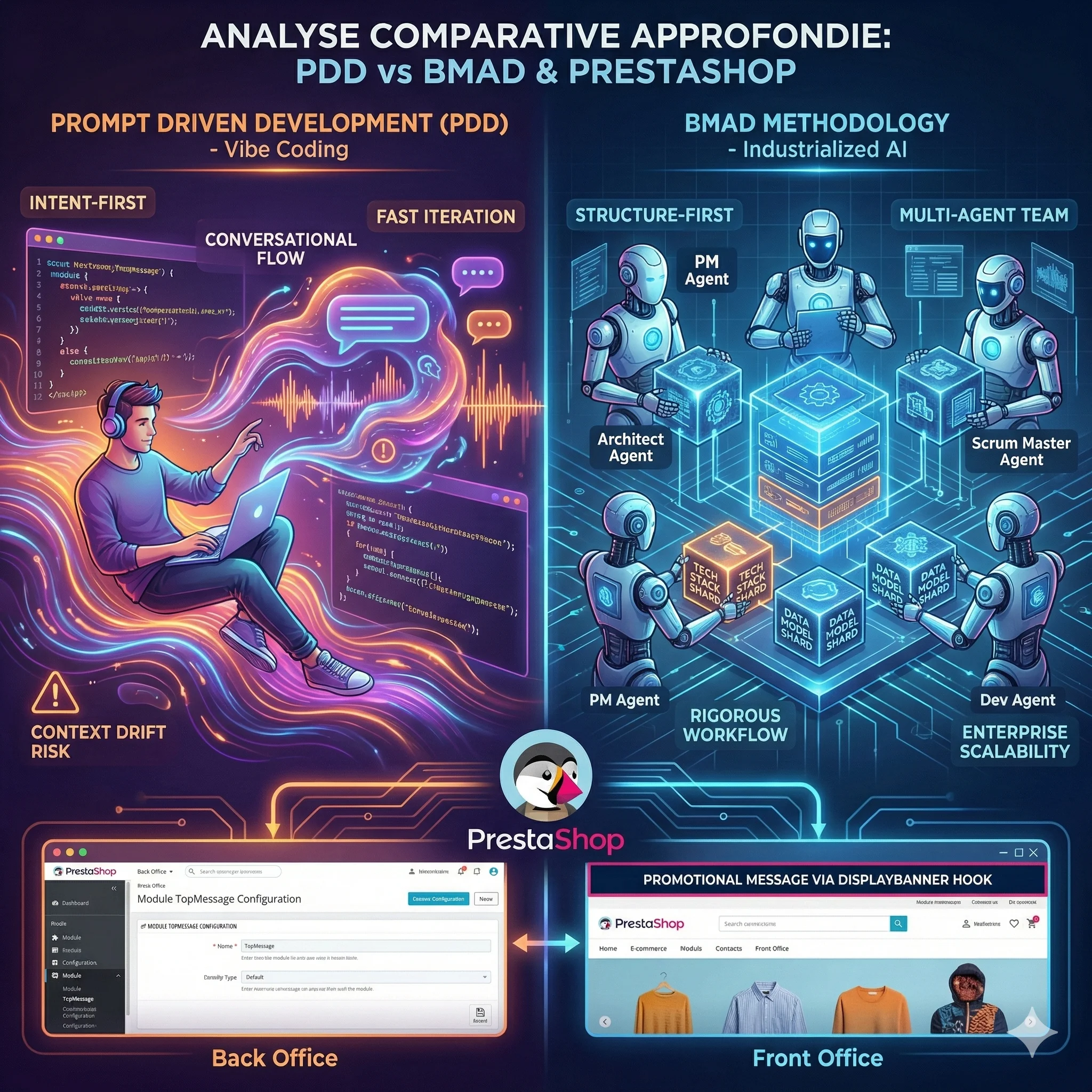

Analyse Comparative Approfondie des Paradigmes de Développement IA : Prompt Driven Development vs Méthodologie BMAD

L'avènement des Grands Modèles de Langage redéfinit le développement logiciel. Deux écoles s'affrontent : le Prompt D...

MIRROR et Engram : Comment l'IA Apprend à Penser et à Se Souvenir

Les modèles de langage actuels oublient, se contredisent et recalculent sans cesse ce qu'ils devraient simplement se ...

Découvrez mes autres articles

Guides e-commerce, tutoriels PrestaShop et bonnes pratiques pour développeurs

Voir tous les articles