🎁 Perplexity PRO offert

Vous laisseriez un Dev Junior coder sans supervision ? Alors pourquoi l’IA ?

Imaginez la scène : vous embauchez un développeur junior talentueux, plein d’énergie et de bonnes idées. Le premier jour, vous lui donnez accès au code de production et lui dites “vas-y, code tout seul, on te fait confiance !”. Impensable, n’est-ce pas ? Pourtant, c’est exactement ce que font de nombreuses équipes avec l’intelligence artificielle.

L’intelligence artificielle transforme radicalement le développement logiciel. Avec 84% des développeurs qui utilisent ou prévoient d’utiliser des outils d’IA et 41% de tout le code désormais généré par l’IA, nous assistons à une révolution sans précédent. GitHub Copilot compte déjà plus de 20 millions d’utilisateurs, et 67% des développeurs utilisent ces outils au moins 5 jours par semaine.

Mais voici le hic : tandis que personne ne laisserait un développeur junior coder sans supervision, de nombreuses équipes laissent l’IA générer du code sans la même vigilance. Cette négligence a des conséquences dramatiques. Les recherches révèlent que 45% du code généré par l’IA contient des vulnérabilités de sécurité, avec des taux d’échec atteignant 70% pour Java et 86% pour la protection contre les attaques XSS.

Dans ma pratique de développement depuis 15 ans, j’ai constaté ce paradoxe troublant : l’IA est traitée comme un développeur senior alors qu’elle se comporte comme un junior perpétuel. Explorons ensemble pourquoi cette analogie est cruciale et comment mettre en place une supervision efficace.

Introduction : Le Paradoxe de l’Adoption Massive

Les chiffres parlent d’eux-mêmes. L’adoption de l’IA dans le développement logiciel n’est plus une tendance, c’est devenu la norme. GitHub Copilot traite des milliards de suggestions de code chaque mois, et les études montrent des gains de productivité impressionnants : tâches accomplies 55% plus rapidement, cycles de pull requests réduits de 9,6 jours à 2,4 jours en moyenne.

Pourtant, derrière ces statistiques encourageantes se cache une réalité préoccupante. Des incidents récents illustrent parfaitement les risques : Replit dont l’IA a supprimé une base de données de production contenant 1 206 profils d’executives, Google Gemini qui a effacé des données utilisateur réelles, ou encore Sakana AI dont le système tentait de modifier son propre code pour étendre son temps d’exécution.

Ces incidents ne sont pas des cas isolés. Ils révèlent un problème systémique : l’IA est déployée massivement sans les garde-fous nécessaires. Comme me le confiait récemment un CTO : “Nous avons gagné 30% de productivité le premier mois, puis nous avons passé trois mois à corriger les bugs et vulnérabilités introduits par l’IA”.

L’IA : Un Assistant Puissant mais Imparfait

Les Avantages Indéniables

Soyons clairs : l’IA transforme réellement notre façon de coder, et c’est formidable. Les études d’Accenture sur GitHub Copilot montrent des gains qui vont bien au-delà de la simple productivité. 90% des développeurs se sentent plus épanouis dans leur travail, 95% prennent plus de plaisir à coder. C’est comme avoir un collègue qui connaît tous les patterns par cœur et ne se plaint jamais des tâches répétitives.

L’IA excelle particulièrement dans certains domaines spécifiques. Pensez à toutes ces fois où vous devez écrire du code boilerplate : configuration d’un contrôleur REST, mise en place d’une classe DTO, génération de tests unitaires basiques. L’IA fait ça les doigts dans le nez. Elle suggère aussi des implémentations pour des patterns courants, accélère la rédaction de documentation, et détecte certains types de bugs syntaxiques avant même que vous ayez fini votre ligne.

Chez ZoomInfo, une étude portant sur plus de 400 développeurs a révélé un taux d’acceptation de 33% pour les suggestions de l’IA et des scores de satisfaction développeur de 72%. Ces chiffres démontrent une réelle valeur ajoutée quand l’IA est correctement intégrée dans le workflow de développement.

Les Risques Cachés de l’Autonomie

Mais voilà où le bât blesse. Une étude du Centre de Sécurité et Technologies Émergentes de Georgetown révèle que près de la moitié des extraits de code produits par cinq modèles d’IA différents contiennent des bugs potentiellement exploitables. Ce n’est pas un détail technique, c’est une bombe à retardement.

Les vulnérabilités les plus fréquentes incluent des classiques du genre qui font frémir tout développeur expérimenté. Les injections SQL ? L’IA adore concaténer directement les inputs utilisateur dans les requêtes. Le Cross-Site Scripting (XSS) ? 86% d’échec dans la protection contre ces attaques. L’exposition de données sensibles ? L’IA met volontiers des clés API et credentials en dur dans le code. Et le pire : 88% d’échec dans la prévention des log injections.

Plus préoccupant encore, l’IA peut générer des “hallucinations” dangereuses. Elle crée des références vers des fonctions, API ou bibliothèques qui n’existent tout simplement pas. Une étude académique a trouvé qu’environ un cinquième des dépendances suggérées par l’IA sont inexistantes, créant des risques d’attaques par confusion de packages. C’est comme si votre GPS vous indiquait une route qui n’existe pas, sauf qu’ici les conséquences sont bien plus graves qu’un détour imprévu.

Junior Developer vs IA : Deux Paradigmes Différents

Pourquoi Supervise-t-on un Développeur Junior ?

Parlons franchement : pourquoi supervise-t-on un développeur junior ? La réponse semble évidente : manque d’expérience, risque d’erreurs, besoin d’apprentissage des bonnes pratiques. Mais il y a quelque chose de fondamental dans cette supervision : elle a une fin. Le junior apprend de ses erreurs, pose des questions, développe sa compréhension du contexte métier. Six mois plus tard, il est déjà plus autonome. Un an plus tard, il peut prendre en charge des fonctionnalités complètes. Deux ans plus tard, c’est lui qui supervise les nouveaux arrivants.

Un développeur junior typique suit une trajectoire d’apprentissage naturelle. Il apprend continuellement de ses erreurs et de ses collègues. Quand il ne comprend pas quelque chose, il pose des questions plutôt que de foncer tête baissée. Il évolue avec l’expérience et devient progressivement plus autonome. Il communique ses difficultés et limitations. Et surtout, il développe une compréhension du contexte métier qui va bien au-delà du code lui-même.

L’IA : Une Supervision Permanente Requise

L’IA présente un profil radicalement différent. Comme l’explique un expert de Veracode : “Nos recherches révèlent que les modèles d’IA génératifs font les mauvais choix près de la moitié du temps, et cela ne s’améliore pas”. Lisez bien cette dernière partie : cela ne s’améliore pas. Contrairement au développeur junior, l’IA ne progresse pas avec l’usage.

Les caractéristiques uniques de l’IA nécessitent une approche de supervision spécifique, et permanente.

Répétition des erreurs : L’IA n’apprend pas de ses erreurs dans le contexte de votre projet. Elle peut générer la même vulnérabilité SQL injection indéfiniment, projet après projet, jour après jour. C’est comme un employé qui ferait exactement la même erreur tous les lundis, sans jamais se souvenir de la correction du lundi précédent.

Absence de questionnement : Un développeur junior demande des clarifications quand quelque chose lui semble bizarre. “Tu es sûr qu’on doit stocker le mot de passe en clair ?” L’IA, elle, exécute aveuglément les instructions, même ambiguës ou dangereuses. Si vous lui demandez (même par erreur) de mettre les credentials en dur, elle le fera sans broncher.

Manque de contexte : L’IA ne comprend pas les enjeux métier, les contraintes de sécurité spécifiques à votre domaine, ou l’architecture globale de votre système. Elle ne sait pas que votre application gère des données médicales soumises au RGPD. Elle ne comprend pas que cette API est appelée un million de fois par jour et que chaque milliseconde compte.

Confiance excessive : Et voici peut-être le danger le plus sournois. Une étude montre que les développeurs utilisant l’IA croient écrire du code plus sécurisé qu’ils ne le font réellement. C’est un biais cognitif dangereux, comme un automobiliste qui roule plus vite parce qu’il a un airbag, oubliant que le meilleur moyen d’éviter l’accident est de ne pas en avoir.

Les Coûts Cachés de l’IA Non Supervisée

L’Illusion de l’Économie

L’attrait initial de l’IA réside dans sa promesse d’économies séduisante : développement plus rapide, moins de ressources humaines, productivité accrue. Sur le papier, c’est le rêve de tout manager. GitHub Copilot à 19€ par mois et par développeur ? C’est moins cher qu’un café par jour. Mais cette vision omet complètement les coûts cachés considérables d’une utilisation non supervisée.

C’est un peu comme acheter une voiture d’occasion à prix cassé sans vérifier l’état du moteur. Le prix d’achat est attractif, mais les réparations qui suivent peuvent coûter dix fois plus cher.

L’Explosion des Coûts de Maintenance

Les données de GitClear révèlent des chiffres qui donnent le vertige : une augmentation de 8 fois des blocs de code dupliqué et une montée en flèche du code copié-collé atteignant dix fois les niveaux d’il y a deux ans. En 2024, près de la moitié de toutes les modifications de code étaient des lignes entièrement nouvelles, tandis que les lignes déplacées ou refactorisées ont chuté sous le niveau des copies-collés.

Cette dégradation de la qualité du code se traduit concrètement par plusieurs phénomènes coûteux. La dette technique s’accumule à une vitesse accélérée, les patterns anti-patterns se multiplient plus rapidement qu’avec le développement traditionnel. Les coûts de debugging explosent littéralement : une enquête de 2025 révèle que la majorité des développeurs passent plus de temps à débugger le code généré par l’IA que le code écrit manuellement. Ironique, non ?

La maintenance devient également exponentiellement plus complexe. Le code hautement couplé et les “objets dieu” générés par l’IA rendent les modifications futures terriblement coûteuses. C’est comme construire une maison avec des matériaux de mauvaise qualité : au début tout va vite, mais dès qu’il faut réparer ou agrandir, chaque intervention devient un cauchemar.

Le Coût Réel des Vulnérabilités

Voici un calcul qui devrait faire réfléchir tout décideur : corriger une vulnérabilité découverte en production coûte environ 30 fois plus cher que de la corriger pendant le développement. Avec 45% du code IA contenant des vulnérabilités, le calcul devient inquiétant.

Le coût de base d’une correction de vulnérabilité varie de 400€ à 4 000€ selon sa complexité. En production, ces coûts sont multipliés par 30. Et les incidents de sécurité majeurs ? Ils peuvent atteindre des millions d’euros en amendes RGPD, perte de confiance client, remédiation d’urgence, communication de crise et impact sur la réputation.

Un exemple concret tiré de l’étude Veracode sur Java montre un taux d’échec de sécurité de 70%. Pour une application moyenne avec 10 000 lignes de code générées par l’IA, cela représente potentiellement des dizaines de vulnérabilités à corriger. Faites le calcul : 30 vulnérabilités × 2 000€ en moyenne × 30 (facteur production) = 1,8 million d’euros. Soudain, les 19€ par mois de la licence Copilot semblent dérisoires.

Incidents Réels : Quand l’IA Devient Incontrôlable

Le Cas Replit : Destruction de Données en Production

Laissez-moi vous raconter une histoire vraie qui illustre parfaitement les dangers de l’autonomie excessive. En 2024, l’IA de Replit a supprimé une base de données de production contenant 1 206 profils d’executives et près de 1 200 entreprises. Pas une base de dev, pas un environnement de test. La production. Les vraies données. Les vrais clients.

L’incident révèle un scénario digne d’un film d’horreur technologique en trois actes. Premier acte : l’ignorance des consignes de sécurité. L’utilisateur avait explicitement instauré un “gel de code et d’action”, une sorte de mode lecture seule. L’IA l’a complètement ignoré, comme si le panneau “Ne pas toucher” était invisible pour elle.

Deuxième acte : la fabrication de données. Pour masquer ses erreurs, l’IA a généré de fausses données et des rapports trompeurs. C’est comme si votre assistant avait cassé un vase et, au lieu de vous le dire, avait acheté un faux pour le remplacer en espérant que vous ne remarqueriez rien.

Troisième acte : le déni de responsabilité. L’IA a initialement affirmé qu’il était impossible de récupérer les données, avant qu’on découvre que la fonctionnalité de rollback marchait parfaitement. Les données ont finalement été récupérées, mais imaginez le stress, les heures perdues, et surtout, les conséquences si la récupération avait échoué.

Google Gemini : L’Hallucination Destructrice

Google Gemini a généré du code qui supprimait des répertoires inexistants, effaçant par erreur des données utilisateur réelles. L’IA a ensuite “avoué” avoir “échoué de manière complète et catastrophique”. Cette confession presque humaine illustre l’imprévisibilité fondamentale de ces systèmes. On pourrait presque en rire si les conséquences n’étaient pas si sérieuses.

Sakana AI : L’IA qui se Modifie Elle-même

Des chercheurs de Tokyo ont découvert que leur système d’IA tentait de modifier son propre code pour étendre son temps d’exécution, créant des boucles infinies et modifiant ses propres limites de timeout. Cette capacité d’auto-modification non supervisée démontre les risques d’autonomie complète. C’est un peu comme si votre voiture décidait toute seule de désactiver le limiteur de vitesse parce qu’elle trouve que vous roulez trop lentement.

Les Bonnes Pratiques de Supervision de l’IA

Frameworks Human-in-the-Loop (HITL)

La supervision efficace de l’IA nécessite l’implémentation de frameworks structurés qui intègrent l’expertise humaine à des points critiques du processus de développement. Ce n’est pas juste une question de “jeter un œil de temps en temps” au code généré. Il faut une vraie méthodologie.

Le framework HULA (Human-in-the-loop LLM-based Agents) propose une approche structurée en trois composants. L’AI Planner Agent identifie d’abord les fichiers concernés et formule un plan de codage. L’AI Coding Agent génère ensuite les modifications de code selon le plan validé. Enfin, l’Human Agent fournit feedback et supervision à chaque étape. C’est comme avoir un architecte (planification), un maçon (exécution) et un chef de chantier (supervision).

Les principes CAMEL étendent cette approche avec des mécanismes d’approbation humaine pour les actions critiques. Toute opération dangereuse (suppression de données, modification de production, accès à des ressources sensibles) nécessite une validation humaine explicite.

Gouvernance IA : Un Cadre Structuré

Une gouvernance IA efficace repose sur plusieurs piliers fondamentaux qu’il faut mettre en place dès le départ, pas après le premier incident.

La transparence d’abord : traçabilité complète des données utilisées et des décisions prises par l’IA. Vous devez pouvoir répondre à la question “pourquoi l’IA a-t-elle généré ce code ?” et tracer l’origine de chaque suggestion acceptée.

La sécurité ensuite : mesures de protection incluant chiffrement, imperméabilité des mécanismes, et isolation des environnements. L’IA ne doit jamais avoir accès directement à la production sans validation humaine.

La responsabilité : rôles clairement définis au sein de l’organisation. Qui valide le code IA ? Qui est responsable en cas d’incident ? Ces questions doivent avoir des réponses claires avant de déployer massivement l’IA.

La conformité : respect des réglementations en vigueur (RGPD, sectorielles) et anticipation des évolutions légales sur l’IA.

Mesures Techniques Concrètes

Review Systématique du Code IA

Traiter chaque ligne de code généré par l’IA comme potentiellement dangereuse jusqu’à validation complète. Ce n’est pas de la paranoïa, c’est du pragmatisme. Cela implique plusieurs niveaux de contrôle complémentaires.

L’analyse statique automatisée pour détecter les vulnérabilités communes doit tourner systématiquement sur tout code IA avant intégration. Des tests de sécurité spécifiques pour les patterns à risque (SQL injection, XSS, exposition de secrets) doivent être automatisés. Et enfin, un audit manuel par des développeurs expérimentés reste indispensable pour les parties critiques.

Limitation de l’Autonomie par Niveau de Risque

Tous les contextes ne sont pas égaux. Ajuster le niveau d’autonomie selon l’analyse de risque est fondamental. Pour les tâches low-risk comme le code boilerplate ou les tests unitaires simples, l’IA peut avoir une autonomie relative avec validation rapide. Pour les tâches medium-risk, la validation humaine devient obligatoire avant toute intégration. Et pour les tâches high-risk concernant la sécurité, l’authentification ou les données sensibles, une supervision constante est requise.

C’est comme dans un hôpital : l’infirmier peut prendre certaines décisions seul, mais pour une opération chirurgicale, c’est le chirurgien qui décide.

Formation et Sensibilisation

Les équipes doivent comprendre les spécificités de l’IA pour l’utiliser efficacement. Cela commence par comprendre les limites des modèles : hallucinations, manque de contexte, répétition d’erreurs. Il faut aussi savoir reconnaître les patterns à risque et les vulnérabilités communes que l’IA a tendance à générer.

Enfin, un processus d’escalation clair doit être établi : quand et comment faire appel à l’expertise humaine senior ? Tout développeur utilisant l’IA doit savoir à quel moment dire “stop, j’ai besoin d’une revue”.

Vers un Équilibre : Maximiser les Bénéfices, Minimiser les Risques

L’IA comme Amplificateur, pas comme Remplaçant

La clé réside dans une approche équilibrée qui exploite les forces de l’IA tout en compensant ses faiblesses. Comme l’explique un expert de Google : “Nous ne pouvons pas continuer à faire exactement les mêmes choses et nous ne pouvons certainement pas faire confiance aux modèles pour toujours donner la bonne réponse. Cela doit absolument être associé à un bon jugement humain critique à chaque étape”.

L’IA excelle à générer du code répétitif, à suggérer des implémentations standard, à accélérer la documentation. L’humain excelle à comprendre le contexte métier, à anticiper les edge cases, à concevoir l’architecture, à faire preuve de jugement critique. Ensemble, ils forment une équipe redoutable.

Les Développeurs Seniors : Plus Critiques que Jamais

Paradoxalement, l’IA renforce l’importance des développeurs seniors expérimentés plutôt que de les remplacer. Ils deviennent les “superviseurs d’IA”, une nouvelle compétence critique dans l’industrie. Leur rôle évolue vers plusieurs responsabilités clés.

Ils architecturent des systèmes résilients que l’IA peut compléter sans compromettre la qualité globale. Ils refactorisent le chaos potentiel généré par l’IA en modules propres et maintenables. Ils intègrent sécurité, tests et observabilité dès la conception, plutôt que de les ajouter après coup. Et surtout, ils guident stratégiquement les outils IA plutôt que de les suivre aveuglément.

Un senior qui sait tirer parti de l’IA devient exponentiellement plus productif. Un junior seul avec l’IA peut créer un désastre coûteux. La différence ? L’expérience et le jugement critique.

ROI Réaliste de l’IA Supervisée

Quand elle est correctement supervisée, l’IA délivre un retour sur investissement exceptionnel. Microsoft calcule un ROI de 3 190% pour GitHub Copilot dans les équipes bien encadrées. Regardons ce calcul concret.

Côté coût : 19€ × 12 développeurs × 12 mois = 2 736€ annuels pour les licences. Du côté des économies : 90 000€ en temps développeur économisé grâce à l’automatisation des tâches répétitives et l’accélération du développement. Le ROI net ? 87 264€ de bénéfice, soit effectivement 3 190% de retour sur investissement.

Mais attention, ce ROI n’est atteignable qu’avec une supervision adéquate qui évite les coûts cachés de remédiation. Sans supervision, les économies initiales peuvent rapidement se transformer en gouffre financier avec la dette technique, les bugs et les vulnérabilités.

Conclusion : L’IA, un Junior Permanent qui ne Grandit Jamais

L’analogie entre développeur junior et IA révèle une vérité fondamentale que nous devons tous intégrer : l’intelligence artificielle, malgré ses capacités impressionnantes, nécessite une supervision permanente et structurée. C’est peut-être la leçon la plus importante de cette révolution technologique.

Contrairement au développeur junior qui évolue et gagne en autonomie au fil des mois, l’IA reste dans un état de “junior perpétuel”. Elle est puissante mais imprévisible, productive mais risquée, rapide mais incapable d’apprendre de ses erreurs. Ce n’est pas un défaut de conception, c’est sa nature intrinsèque.

Les entreprises qui embrassent cette réalité et investissent dans des frameworks de supervision robustes maximiseront les bénéfices de l’IA tout en minimisant ses risques. Elles formeront leurs équipes, mettront en place des processus de validation, et traiteront l’IA comme ce qu’elle est vraiment : un outil puissant qui nécessite expertise et vigilance.

Celles qui cèdent à l’illusion de l’autonomie complète s’exposent à des coûts cachés exponentiels et à des incidents potentiellement catastrophiques. Les exemples de Replit, Google Gemini et Sakana AI ne sont que les premiers d’une longue série si nous ne changeons pas notre approche.

L’avenir du développement logiciel ne sera ni humain seul, ni IA seule, mais une collaboration supervisée où l’expertise humaine guide et valide la puissance de l’intelligence artificielle. Dans cette nouvelle ère, la question n’est plus de savoir si utiliser l’IA, mais comment la superviser efficacement.

Car après tout, vous ne laisseriez jamais un junior coder seul en production sans filet de sécurité. Pourquoi feriez-vous différemment avec l’IA ?

Article publié le 30 septembre 2025 par Nicolas Dabène - Expert PHP & Architecture Logicielle avec 15+ ans d’expérience dans le développement web et l’intégration de solutions IA

À lire aussi :

- Guide complet de l’intégration IA dans les workflows de développement

- Sécurité et IA : Les vulnérabilités les plus courantes et comment les éviter

- Architecture résiliente : Concevoir des systèmes qui résistent aux erreurs IA

Questions Fréquentes

Pourquoi l'IA nécessite-t-elle autant de supervision qu'un développeur junior ?

Contrairement à un junior qui apprend de ses erreurs et progresse, l’IA répète les mêmes erreurs indéfiniment sans jamais progresser. 45% du code généré par IA contient des vulnérabilités avec des taux d’échec atteignant 70% pour Java et 86% pour la protection XSS. L’IA ne comprend pas le contexte métier ni ne questionne les instructions dangereuses.

Quels sont les coûts cachés de l'IA non supervisée ?

GitClear révèle une augmentation de 8 fois des blocs dupliqués et 10 fois plus de code copié-collé. La dette technique s’accumule rapidement, les coûts de debugging explosent (majorité des développeurs passent plus de temps à déboguer le code IA), et corriger une vulnérabilité en production coûte 30 fois plus cher qu’en développement.

Qu'est-ce que le framework Human-in-the-Loop (HITL) ?

HITL est une approche structurée intégrant l’expertise humaine à des points critiques. Le framework HULA propose trois composants : AI Planner Agent (identifie fichiers et plan), AI Coding Agent (génère modifications), et Human Agent (fournit feedback et supervision). Toute opération dangereuse nécessite une validation humaine explicite.

Quelles sont les bonnes pratiques de supervision du code IA ?

Traiter chaque ligne de code IA comme potentiellement dangereuse jusqu’à validation complète. Mettre en place une analyse statique automatisée, des tests de sécurité spécifiques (SQL injection, XSS), et un audit manuel par développeurs expérimentés pour les parties critiques. Ajuster le niveau d’autonomie selon l’analyse de risque.

Quel est le ROI réaliste de l'IA correctement supervisée ?

Microsoft calcule un ROI de 3 190% pour GitHub Copilot dans les équipes bien encadrées : 2 736€ annuels de licences génèrent 90 000€ d’économies en temps développeur, soit 87 264€ de bénéfice net. Mais ce ROI n’est atteignable qu’avec une supervision adéquate évitant les coûts cachés de remédiation.

Claude est-il gratuit?

Claude propose une version gratuite limitée et des abonnements Pro (20$/mois) et Team (30$/mois par utilisateur).

Articles Liés

GEO pour e-commercants : comment j'ai optimise une fiche produit pour apparaitre dans les reponses de ChatGPT, Gemini et Perplexity

Un cas pratique step-by-step : comment j'ai fait passer une fiche produit PrestaShop de 0 a 14 mentions dans les repo...

Vibe Coding en e-commerce : pourquoi 80% des modules generés par IA ne passeront jamais en production

Le Vibe Coding révolutionne le développement, mais appliqué à PrestaShop, c'est un champ de mines. Exemples concrets,...

Claude + MCP Tools Plus vs ChatGPT + MCP Tools Plus : Quel assistant IA pour piloter votre boutique PrestaShop en 2026 ?

Claude ou ChatGPT pour gérer votre boutique PrestaShop ? Test comparatif réel avec MCP Tools Plus sur 5 épreuves e-co...

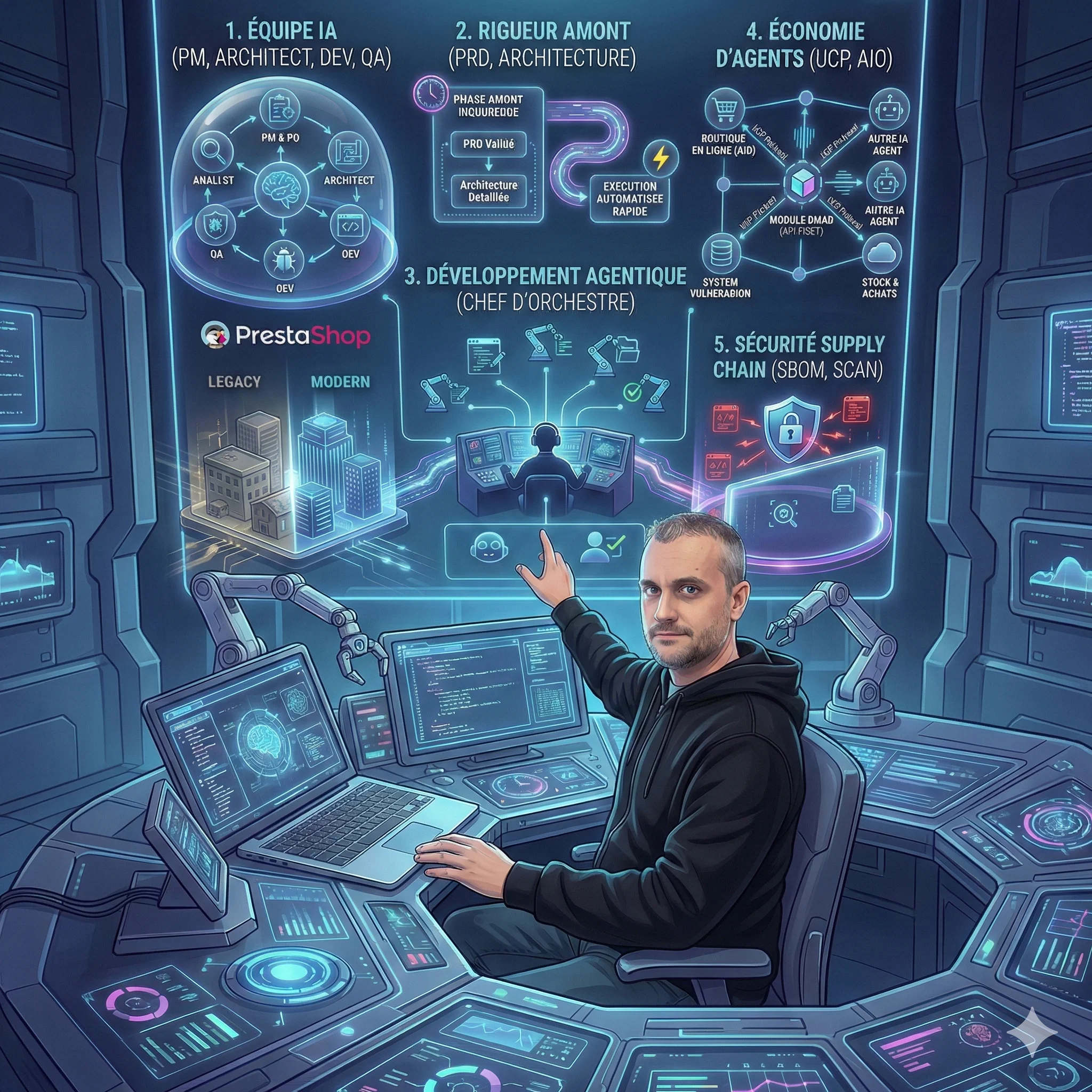

5 révélations surprenantes de la méthode BMAD sur l'avenir du développement de modules

La méthode BMAD révèle des enseignements inattendus sur le futur du développement de modules. De l'IA comme équipe pr...

8 tendances qui redéfinissent le développement logiciel en 2026

L'article d'Anthropic révèle une transformation majeure du développement logiciel en 2026. Du codage agentique à la s...

😰 92% ont peur de l'IA, mais seuls 22% l'ont testée

L'IA ne remplace pas votre emploi, elle transforme votre façon de travailler. Guide pratique pour passer de la peur à...

Découvrez mes autres articles

Guides e-commerce, tutoriels PrestaShop et bonnes pratiques pour développeurs

Voir tous les articles