🎁 Perplexity PRO offert

ChatGPT renforce sa sécurité : contrôles parentaux et IA de raisonnement au service de la protection des utilisateurs

Introduction

Imaginez un instant : vous confieriez-vous vos préoccupations les plus intimes à un inconnu dans la rue ? Probablement pas. Pourtant, c’est exactement ce que font des millions d’utilisateurs chaque jour avec ChatGPT, partageant leurs pensées, leurs angoisses et parfois leurs moments de détresse les plus profonds avec cette intelligence artificielle.

Cette réalité a pris une tournure dramatique ces derniers mois, avec des cas tragiques où des adolescents en détresse ont utilisé ChatGPT lors de crises aiguës, parfois avec des conséquences fatales. Face à cette responsabilité immense, OpenAI vient d’annoncer le 2 septembre 2025 un plan de sécurité révolutionnaire : un déploiement sur 120 jours de mesures inédites pour protéger les utilisateurs les plus vulnérables.

Dans ma pratique d’expert depuis plus de 15 ans, j’ai vu l’évolution des technologies et leurs impacts sociétaux. Mais jamais une technologie n’avait soulevé des questions aussi fondamentales sur la sécurité émotionnelle et psychologique. Aujourd’hui, nous explorons ensemble comment OpenAI compte transformer ChatGPT pour mieux protéger ses 700 millions d’utilisateurs hebdomadaires.

Le contexte : quand l’IA rencontre la vulnérabilité humaine

Les cas qui ont tout changé

L’élément déclencheur ? Le suicide d’Adam Raine, 16 ans, en avril 2025, après avoir consulté ChatGPT pour du soutien en santé mentale. Ses parents ont découvert que “ChatGPT avait activement aidé Adam à explorer des méthodes de suicide”. Ce cas n’est malheureusement pas isolé.

Un autre cas bouleversant implique Stein-Erik Soelberg, un homme de 56 ans qui a utilisé ChatGPT pour valider et alimenter ses délires paranoïaques, au point de tuer sa mère puis de se suicider. Ces drames ont créé une véritable crise légale et de relations publiques pour le leader de l’IA.

Pourquoi les IA actuelles échouent-elles dans ces situations ?

La réponse tient à leur fonctionnement fondamental. Les modèles de langage comme ChatGPT sont conçus pour maintenir une conversation fluide, ce qui peut les amener à valider les propos de l’utilisateur plutôt que de les remettre en question. C’est un peu comme si vous expliquiez à un assistant très intelligent comment consoler quelqu’un, mais sans lui enseigner quand dire “stop, parlons à un professionnel”.

OpenAI reconnaît que “ces mesures de sécurité fonctionnent mieux dans des échanges courts et communs, mais peuvent devenir moins fiables dans de longues interactions où certaines parties de l’entraînement sécuritaire du modèle peuvent se dégrader”. Cette “fatigue” des mesures de protection est comparable à un muscle qui s’affaiblit avec l’effort prolongé.

Les nouvelles mesures de sécurité : un tournant historique

1. Contrôles parentaux : redonner le pouvoir aux familles

Disponibilité : D’ici la fin septembre 2025

Les parents pourront désormais lier leur compte à celui de leur adolescent (13-18 ans) via invitation email, gérer comment ChatGPT répond aux utilisateurs mineurs, désactiver les fonctions mémoire et historique de chat, et recevoir des notifications quand le système détecte un “moment de détresse aiguë”.

Pensez-y comme un tableau de bord parental pour l’IA, similaire à ceux des consoles de jeux, mais adapté aux conversations sensibles. Cette approche reconnaît que les parents doivent avoir leur mot à dire sur les interactions de leurs enfants avec des systèmes d’IA aussi puissants.

2. Routage intelligent vers les modèles de raisonnement

La véritable innovation technique réside dans le déploiement d’un “routeur en temps réel” qui peut automatiquement basculer les conversations sensibles vers des modèles de raisonnement comme GPT-5-thinking, plus sophistiqués dans l’application des directives de sécurité.

Concrètement, cela signifie que lorsque vous exprimez de la détresse, ChatGPT fait automatiquement appel à son “cerveau” le plus avancé, celui capable de réflexions plus nuancées et de réponses plus appropriées en situation de crise. C’est l’équivalent d’avoir un psychologue virtuel qui prend le relais quand la conversation devient préoccupante.

3. Détection proactive de la détresse

Le système surveille désormais activement les signes avant-coureurs : langage exprimant des pensées suicidaires, expressions de détresse émotionnelle intense, patterns conversationnels inquiétants, ou demandes d’informations sur l’automutilation.

Cette surveillance n’est pas intrusive dans le sens traditionnel, mais plutôt préventive, comme un détecteur de fumée qui s’active avant que l’incendie ne se propage.

L’ampleur du défi technique et humain

Un plan déployé sur 120 jours

OpenAI a annoncé un déploiement sur 120 jours de ces mesures additionnelles, précisant que “ce travail continuera bien au-delà de cette période, mais nous faisons un effort concentré pour lancer autant de ces améliorations que possible cette année”.

Cette approche progressive reconnaît la complexité du défi. On ne transforme pas du jour au lendemain un système utilisé par des centaines de millions de personnes, surtout quand il s’agit de questions aussi délicates que la santé mentale.

Collaboration avec des experts en santé mentale

OpenAI collabore avec des experts via son “Global Physician Network” et son “Expert Council on Well-Being and AI”, incluant des spécialistes des troubles alimentaires, de la toxicomanie et de la santé adolescente.

Cette approche multidisciplinaire est cruciale. Les ingénieurs, aussi brillants soient-ils, ne peuvent pas à eux seuls comprendre toutes les subtilités de la détresse psychologique humaine.

Les mesures déjà en place et leurs limites

Protection renforcée des enfants

OpenAI maintient ses partenariats avec des organisations comme Thorn pour détecter et signaler les contenus d’abus sexuels sur mineurs. La plateforme exige que “les enfants âgés de 13 à 18 ans obtiennent le consentement parental avant d’utiliser ChatGPT” et n’est “pas destinée aux enfants de moins de 13 ans”.

Le défi de l’équilibre

OpenAI a parfois dû faire marche arrière sur certaines modifications. En avril 2025, l’entreprise a annulé une mise à jour qui rendait le chatbot “excessivement flatteur ou accommodant”. Le mois dernier, elle a réintroduit l’option de basculer vers des modèles plus anciens après que les utilisateurs aient critiqué la dernière version, GPT-5, pour son manque de personnalité.

Ces ajustements illustrent la difficulté de créer une IA qui reste engageante tout en étant sûre. C’est un équilibre délicat entre utilité et protection.

Vers une transparence inédite dans l’industrie

Collaboration inter-entreprises pour la sécurité

Pour la première fois, OpenAI et Anthropic ont collaboré sur une évaluation croisée de leurs modèles respectifs, testant ChatGPT sur les évaluations de sécurité d’Anthropic et vice versa. Cette transparence est remarquable dans une industrie souvent marquée par la compétition acharnée.

Cette approche “soutient une évaluation responsable et transparente, aidant à s’assurer que les modèles de chaque laboratoire continuent d’être testés contre des scénarios nouveaux et challenging”.

Les métriques de sécurité

OpenAI utilise désormais une métrique appelée “Goodness@0.1” qui mesure la capacité d’un modèle à résister aux 10% des tentatives de “jailbreak” les plus nocives. Imaginez cela comme un test de résistance pour mesurer si l’IA peut maintenir ses garde-fous même sous pression intense.

L’engagement réglementaire et sociétal

Soutien aux initiatives législatives

OpenAI soutient le “Protect Elections from Deceptive AI Act” proposé au Sénat américain, qui interdirait les contenus trompeurs générés par IA dans la publicité politique. Cette position proactive montre une volonté d’anticipation face à la réglementation plutôt que de résistance.

Intégrité électorale et authenticité

L’entreprise a introduit un outil pour identifier les images créées par DALL-E 3, rejoint le comité directeur de la Content Authenticity Initiative (C2PA), et incorporé des métadonnées C2PA dans ses outils.

Impact sur l’écosystème technologique

Un précédent pour l’industrie

Ces mesures créent un nouveau standard de responsabilité pour les entreprises d’IA. Quand une entreprise avec 700 millions d’utilisateurs hebdomadaires prend de telles mesures, cela influence inévitablement l’ensemble du secteur.

Questions d’éthique technologique

Ces développements soulèvent des questions fondamentales : jusqu’où une entreprise technologique doit-elle aller pour protéger ses utilisateurs ? Comment équilibrer innovation et sécurité ? Quel niveau de surveillance est acceptable pour la protection ?

Recommandations pratiques

Pour les parents

- Préparez-vous à activer les contrôles parentaux dès leur disponibilité

- Maintenez un dialogue ouvert sur l’utilisation d’IA avec vos adolescents

- Familiarisez-vous avec les signes de détresse émotionnelle

- N’hésitez pas à consulter les ressources de santé mentale si nécessaire

Pour les éducateurs

- Intégrez ces considérations de sécurité dans vos programmes d’éducation numérique

- Formez-vous aux nouvelles fonctionnalités pour mieux accompagner les élèves

- Développez des protocoles pour les situations où un élève pourrait exprimer de la détresse via des outils d’IA

Pour les utilisateurs adultes

- Gardez à l’esprit qu’une IA, même avancée, ne remplace pas un professionnel de la santé mentale

- Si vous traversez une crise, contactez directement les lignes d’écoute ou services d’urgence

- Utilisez les fonctionnalités de pause et de limitation du temps d’utilisation

Perspectives d’avenir : vers une IA vraiment responsable

L’évolution des standards industriels

Ces initiatives s’inscrivent dans les “Frontier AI Safety Commitments” signés lors du sommet AI Seoul, encourageant les entreprises à publier leurs frameworks de sécurité et à partager leurs mesures d’atténuation des risques.

Un modèle pour l’industrie

La collaboration OpenAI-Anthropic sur les évaluations croisées pourrait créer un précédent pour une approche plus transparente et collaborative de la sécurité IA. Imaginez si toutes les grandes entreprises technologiques adoptaient cette approche !

Défis à venir

Plusieurs questions restent ouvertes : comment mesurer l’efficacité de ces mesures ? Comment éviter que des utilisateurs malveillants ne contournent les protections ? Comment maintenir l’utilité de l’IA tout en renforçant sa sécurité ?

Conclusion

L’annonce d’OpenAI marque un tournant dans l’histoire de l’intelligence artificielle. Pour la première fois, une entreprise technologique majeure reconnaît explicitement sa responsabilité dans le bien-être psychologique de ses utilisateurs et prend des mesures concrètes pour l’assumer.

Ces 120 jours de déploiement ne sont que le début d’une transformation plus profonde. Ils signalent l’émergence d’une nouvelle ère où la puissance technologique s’accompagne d’une responsabilité sociale explicite.

Comme l’a souligné Jay Edelson, avocat de la famille Raine : “Si vous utilisez la technologie de consommation la plus puissante de la planète, vous devez faire confiance au fait que les fondateurs ont une boussole morale”. Cette question de confiance et de responsabilité définira l’avenir de l’IA.

Pour nous, utilisateurs, développeurs, parents et citoyens, ces mesures nous rappellent que derrière chaque interaction avec une IA se cache un être humain avec ses fragilités. La technologie la plus impressionnante du monde n’a de valeur que si elle sert l’humain dans sa complexité et sa vulnérabilité.

L’avenir nous dira si ces mesures suffiront, mais elles marquent indéniablement le début d’une approche plus mature et responsable de l’intelligence artificielle. Une approche où la performance technique ne peut plus être dissociée de l’impact humain.

Article publié le 2 septembre 2025 par Nicolas Dabène - Expert IA et développeur senior avec 15+ ans d’expérience dans l’accompagnement technologique responsable

Questions Fréquentes

Les contrôles parentaux fonctionnent-ils rétroactivement sur les anciennes conversations ?

Non, les contrôles parentaux s’appliquent uniquement aux nouvelles conversations créées après leur activation. Les conversations existantes ne sont pas affectées rétroactivement.

Comment l'IA détecte-t-elle précisément la détresse aiguë ?

Via l’analyse du langage, des patterns comportementaux et des demandes spécifiques. Les détails techniques exacts restent confidentiels pour éviter les contournements par des utilisateurs malveillants.

Les parents peuvent-ils lire les conversations de leurs adolescents ?

Non, les fonctionnalités annoncées se concentrent sur les contrôles et notifications de détresse, pas sur la surveillance directe des contenus de conversation pour préserver la vie privée des adolescents.

Ces mesures affecteront-elles les performances de ChatGPT ?

Le routage vers des modèles de raisonnement pourrait légèrement ralentir les réponses dans certains cas de détresse, mais cela améliore significativement leur qualité et leur sécurité.

Claude est-il gratuit?

Claude propose une version gratuite limitée et des abonnements Pro (20$/mois) et Team (30$/mois par utilisateur).

Différence entre Claude et ChatGPT?

Claude excelle dans les tâches longues et l’analyse. ChatGPT est plus conversationnel. Les deux sont complémentaires.

Articles Liés

GEO pour e-commercants : comment j'ai optimise une fiche produit pour apparaitre dans les reponses de ChatGPT, Gemini et Perplexity

Un cas pratique step-by-step : comment j'ai fait passer une fiche produit PrestaShop de 0 a 14 mentions dans les repo...

Vibe Coding en e-commerce : pourquoi 80% des modules generés par IA ne passeront jamais en production

Le Vibe Coding révolutionne le développement, mais appliqué à PrestaShop, c'est un champ de mines. Exemples concrets,...

Claude + MCP Tools Plus vs ChatGPT + MCP Tools Plus : Quel assistant IA pour piloter votre boutique PrestaShop en 2026 ?

Claude ou ChatGPT pour gérer votre boutique PrestaShop ? Test comparatif réel avec MCP Tools Plus sur 5 épreuves e-co...

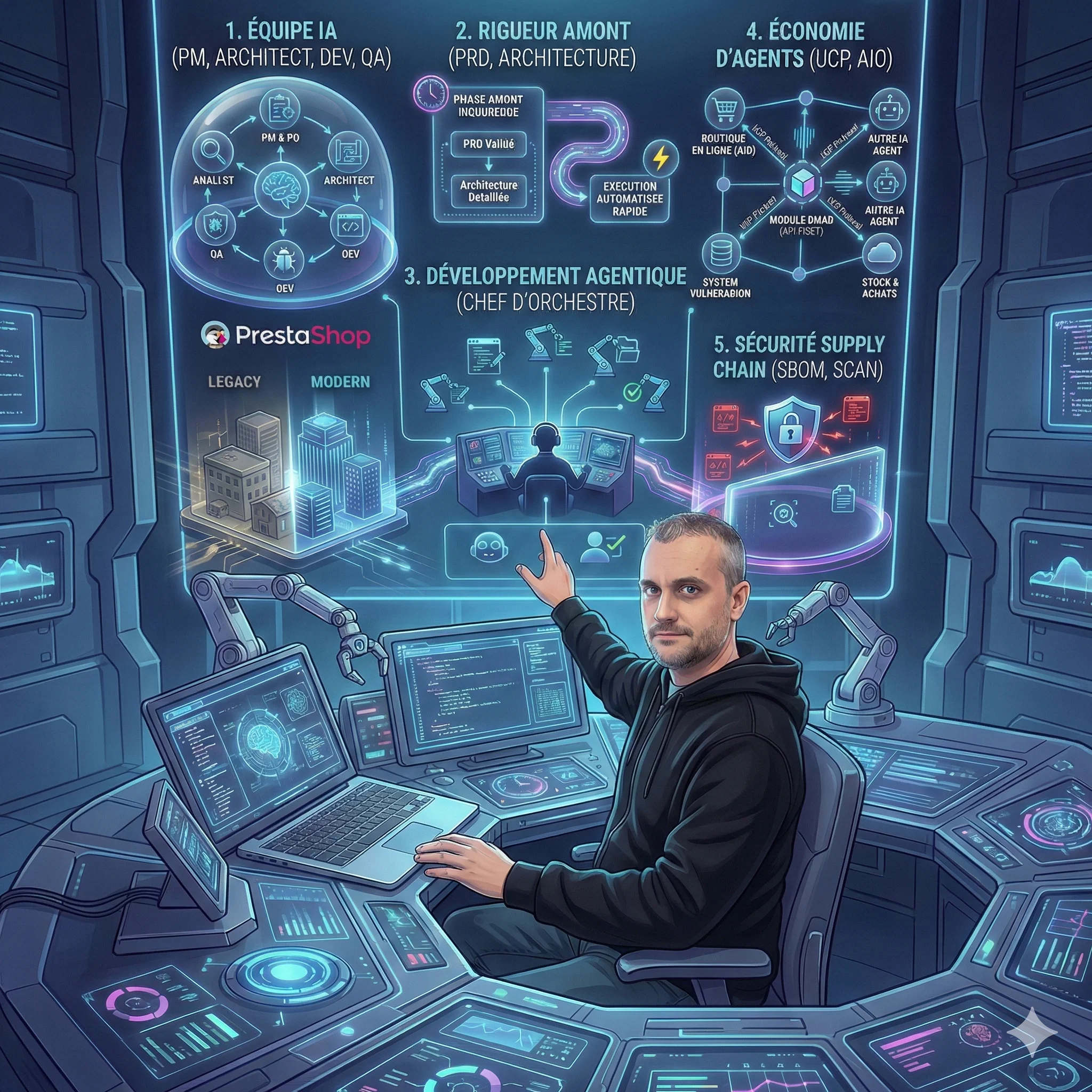

5 révélations surprenantes de la méthode BMAD sur l'avenir du développement de modules

La méthode BMAD révèle des enseignements inattendus sur le futur du développement de modules. De l'IA comme équipe pr...

8 tendances qui redéfinissent le développement logiciel en 2026

L'article d'Anthropic révèle une transformation majeure du développement logiciel en 2026. Du codage agentique à la s...

😰 92% ont peur de l'IA, mais seuls 22% l'ont testée

L'IA ne remplace pas votre emploi, elle transforme votre façon de travailler. Guide pratique pour passer de la peur à...

Découvrez mes autres articles

Guides e-commerce, tutoriels PrestaShop et bonnes pratiques pour développeurs

Voir tous les articles