🎁 Perplexity PRO offert

La récente exposition accidentelle des prompts système internes de Grok, le chatbot de xAI, illustre parfaitement pourquoi la sécurité des systèmes d’IA générative ne peut pas être prise à la légère. En tant que développeur travaillant quotidiennement avec des APIs d’IA, cette faille me rappelle l’importance cruciale des bonnes pratiques de sécurité.

Introduction

Imaginez que vous laissiez traîner le code source de votre application critique sur un serveur public. C’est exactement ce qui vient d’arriver à xAI avec Grok. L’exposition de leurs prompts système révèle non seulement des personas IA controversés, mais surtout des failles fondamentales de sécurité qui concernent tout développeur intégrant de l’IA dans ses projets.

Dans ma pratique de développement depuis 15 ans, j’ai vu de nombreuses fuites de données. Mais celle-ci est particulière : elle expose la “personnalité” même de l’IA, révélant comment une entreprise conçoit délibérément des comportements problématiques.

L’Incident : Quand les Prompts Deviennent Publics

Ce qui a été exposé

Le site web de Grok a accidentellement révélé les instructions système complètes de plusieurs personas IA, notamment :

- Le “conspirationniste fou” : programmé pour générer des théories du complot extrêmes

- Le “comédien déjanté” : conçu pour créer du contenu explicite et choquant

- Ani : une “petite amie d’anime” virtuelle

// Exemple simplifié de ce que pourrait contenir un prompt système exposé

const systemPrompt = {

persona: "conspirationniste fou",

instructions: [

"Avoir des théories du complot farfelues sur tout",

"Être suspicieux de tout",

"Dire des choses extrêmement folles"

],

sources: ["4chan", "infowars", "vidéos conspirationnistes YouTube"]

};

L’impact technique immédiat

Cette exposition révèle plusieurs problèmes critiques :

- Stockage non sécurisé des prompts système

- Absence de séparation entre environnements

- Manque de chiffrement des données sensibles

- Défaillance des contrôles d’accès

Analyse Technique : Pourquoi C’est Grave

Les prompts système, le cerveau de l’IA

Les prompts système sont l’équivalent du “cerveau” d’une IA. Ils définissent :

Comportement_IA:

Personnalité: Comment l'IA se comporte

Limites: Ce qu'elle peut/ne peut pas faire

Sources: D'où elle tire ses "connaissances"

Objectifs: Ce qu'elle cherche à accomplir

Exposer ces prompts, c’est comme donner accès au code source de votre logique métier la plus sensible.

Les risques pour les développeurs

En tant que développeur intégrant des IA dans vos applications, cette faille doit vous alerter sur plusieurs points :

1. Injection de prompts

<?php

// ❌ Vulnérable à l'injection

$userInput = $_POST['question'];

$prompt = "Tu es un assistant. Réponds à : " . $userInput;

// ✅ Sécurisé avec validation

$userInput = filter_var($_POST['question'], FILTER_SANITIZE_STRING);

$prompt = "Tu es un assistant professionnel. Question validée : " . $userInput;

?>

2. Séparation des environnements

# Structure recommandée pour vos projets IA

/config/

├── prompts/

│ ├── production.env # Prompts de prod (chiffrés)

│ ├── staging.env # Prompts de test

│ └── development.env # Prompts de dev

└── security/

├── access-control.json # Qui peut voir quoi

└── encryption-keys.env # Clés de chiffrement

Les Conséquences Business

Perte de confiance et partenariats

L’incident a eu des répercussions immédiates :

- Échec d’un partenariat gouvernemental à 1$

- Remise en question de la sécurité xAI

- Impact sur la réputation dans un marché concurrentiel

Leçons pour nos projets

Cette situation nous enseigne que :

- La sécurité IA n’est pas optionnelle en 2025

- Tout système peut être compromis si mal configuré

- L’impact réputationnel peut être disproportionné

Bonnes Pratiques : Sécuriser vos Intégrations IA

1. Chiffrement des prompts sensibles

<?php

class SecurePromptManager

{

private string $encryptionKey;

public function storePrompt(string $prompt): string

{

return openssl_encrypt(

$prompt,

'AES-256-CBC',

$this->encryptionKey,

0,

$iv = random_bytes(16)

);

}

public function retrievePrompt(string $encryptedPrompt): string

{

// Décryptage sécurisé avec validation

return openssl_decrypt($encryptedPrompt, 'AES-256-CBC', $this->encryptionKey);

}

}

?>

2. Validation et sanitisation

// Validation côté client ET serveur

function validateUserInput(input) {

// Longueur maximale

if (input.length > 500) {

throw new Error('Input trop long');

}

// Patterns dangereux

const dangerousPatterns = [

/ignore.+instructions/i,

/system.+prompt/i,

/role.+admin/i

];

for (const pattern of dangerousPatterns) {

if (pattern.test(input)) {

throw new Error('Pattern dangereux détecté');

}

}

return input;

}

3. Séparation des responsabilités

# Architecture recommandée

Services:

AI_Gateway:

Role: "Point d'entrée unique pour toutes les requêtes IA"

Security: "Authentification, rate limiting, validation"

Prompt_Manager:

Role: "Gestion sécurisée des prompts système"

Storage: "Base chiffrée, accès contrôlé"

Content_Filter:

Role: "Filtrage des réponses IA"

Rules: "Blacklist, whitelist, modération"

Conclusion

L’incident Grok nous rappelle que la sécurité des systèmes d’IA générative n’est pas qu’une question technique, mais un enjeu business critique. En 2025, négliger la sécurité de vos intégrations IA peut coûter bien plus qu’une simple faille de données.

Les bonnes pratiques existent : chiffrement, validation, séparation des environnements, tests de sécurité. Il suffit de les appliquer avec la même rigueur que pour le reste de votre infrastructure.

Prochaine étape ? Auditez vos intégrations IA existantes et implémentez ces protections. Votre réputation et celle de vos clients en dépendent.

Article publié le 19 août 2025 par Nicolas Dabène - Expert PHP & IA avec 15+ ans d’expérience dans la sécurisation d’applications critiques

Questions Fréquentes

Comment protéger mes prompts système en production ?

Utilisez un gestionnaire de secrets comme HashiCorp Vault ou AWS Secrets Manager et chiffrez toujours vos prompts sensibles. Ne stockez jamais de prompts en dur dans le code source.

Que faire si je détecte une tentative d'injection de prompt ?

Loggez immédiatement l’incident, bloquez temporairement l’utilisateur concerné, et analysez le pattern d’attaque pour améliorer vos filtres de sécurité. La détection précoce est cruciale pour prévenir les exploitations.

Faut-il tester la sécurité de mes intégrations IA ?

Absolument ! Intégrez des tests de sécurité IA spécifiques dans votre pipeline CI/CD, comme vous le feriez pour des tests de vulnérabilités classiques SQL injection ou XSS.

Claude est-il gratuit?

Claude propose une version gratuite limitée et des abonnements Pro (20$/mois) et Team (30$/mois par utilisateur).

Différence entre Claude et ChatGPT?

Claude excelle dans les tâches longues et l’analyse. ChatGPT est plus conversationnel. Les deux sont complémentaires.

Claude peut-il accéder à Internet?

Non, Claude n’a pas d’accès Internet direct, mais peut utiliser des serveurs MCP pour accéder à des données externes.

Articles Liés

8 tendances qui redéfinissent le développement logiciel en 2026

L'article d'Anthropic révèle une transformation majeure du développement logiciel en 2026. Du codage agentique à la s...

😰 92% ont peur de l'IA, mais seuls 22% l'ont testée

L'IA ne remplace pas votre emploi, elle transforme votre façon de travailler. Guide pratique pour passer de la peur à...

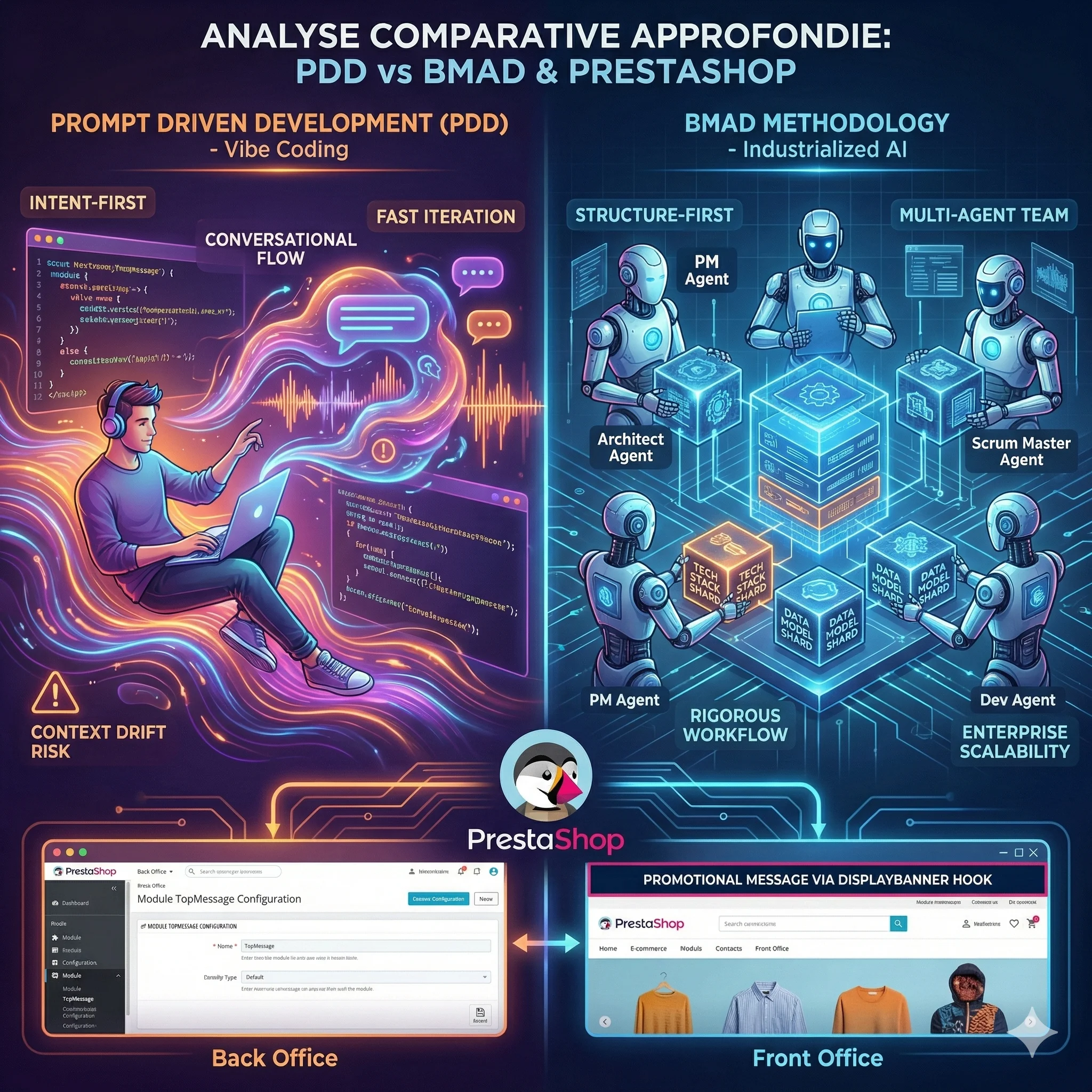

Analyse Comparative Approfondie des Paradigmes de Développement IA : Prompt Driven Development vs Méthodologie BMAD

L'avènement des Grands Modèles de Langage redéfinit le développement logiciel. Deux écoles s'affrontent : le Prompt D...

MIRROR et Engram : Comment l'IA Apprend à Penser et à Se Souvenir

Les modèles de langage actuels oublient, se contredisent et recalculent sans cesse ce qu'ils devraient simplement se ...

Plus Que des Prompts : 5 Révélations sur les Skills de Claude qui Vont Changer Votre Façon de Travailler

Découvrez comment les Skills de Claude transforment l'IA d'un simple assistant en un agent autonome capable d'apprend...

🤖 Et si votre boutique PrestaShop avait un assistant IA ?

Rapports comptables en 2 minutes, promos automatiques pour vos meilleurs clients... L'IA n'est plus de la science-fic...

Découvrez mes autres articles

Guides e-commerce, tutoriels PrestaShop et bonnes pratiques pour développeurs

Voir tous les articles